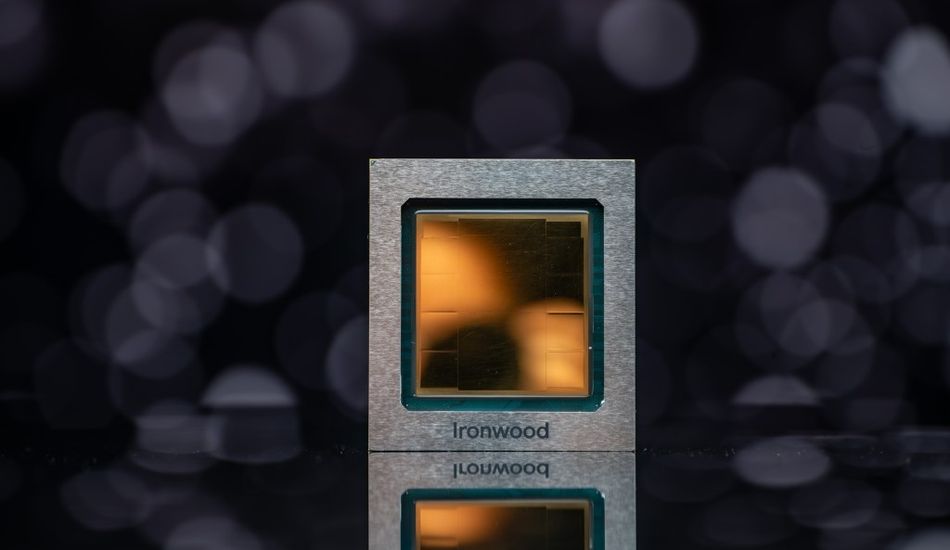

Ironwood de Google: Inférence IA Optimisée pour les clients Cloud

Google vient de dévoiler sa TPU de **septième génération**, nommée Ironwood, lors de la conférence Cloud Next. Cette nouvelle puce d'accélération de l'IA est principalement conçue et optimisée pour l'**inférence IA**, c'est-à-dire l'exécution efficace de modèles d'IA déjà entraînés. Ce lancement place Google fermement sur le marché de plus en plus concurrentiel des accélérateurs d'IA.

Ironwood : puissance et performances

Devant être disponible pour les clients de Google Cloud plus tard cette année, Ironwood sera proposé en deux configurations : un **cluster de 256 puces** et un énorme **cluster de 9 216 puces**. Selon Amin Vahdat, vice-président de Google Cloud, Ironwood est leur « TPU la plus puissante, la plus performante et la plus économe en énergie à ce jour », spécialement conçue pour alimenter des **modèles d'IA inférentiels** à grande échelle.

Face à l'intensification de la concurrence de sociétés comme Nvidia, Amazon et Microsoft, la décision de Google d'améliorer son matériel d'IA est cruciale. Amazon propose les processeurs Trainium, Inferentia et Graviton via AWS, tandis que Microsoft fournit des instances Azure alimentées par sa puce Cobalt 100 AI.

Les benchmarks internes de Google indiquent qu'Ironwood peut atteindre une puissance de calcul maximale de **4 614 TFLOPs**. Chaque puce dispose de **192 Go de RAM** dédiée avec une bande passante d'environ 7,4 Tbit/s, garantissant un accès rapide aux données.

Noyau spécialisé et intégration

Ironwood est doté d'un noyau spécialisé amélioré appelé **SparseCore**, conçu pour traiter efficacement les données courantes dans les systèmes avancés de classement et de recommandation. Ce noyau excelle dans les tâches telles que la suggestion de produits aux utilisateurs. L'architecture minimise le mouvement des données et la latence, ce qui entraîne des **économies d'énergie** considérables, selon Google.

Google prévoit d'intégrer Ironwood dans son **AI Hypercomputer**, un cluster informatique modulaire au sein de Google Cloud. Cette intégration promet d'améliorer encore les performances et l'évolutivité des charges de travail d'IA.

Vahdat conclut qu'Ironwood représente une « percée unique dans l'ère de l'inférence », offrant une puissance de calcul accrue, une capacité de mémoire, des avancées en matière de réseau et une fiabilité améliorée.

1 Image de Inférence IA:

Source: TechCrunch