Robots d'Exploration Web IA vs. Développeurs: La Bataille Hilarante

Les robots d'exploration web IA sont de plus en plus considérés comme une nuisance, ignorant souvent les fichiers robots.txt et surchargeant les sites web, en particulier ceux hébergeant des projets de logiciels libres et open source (FOSS). Ces projets, de par leur nature, sont plus vulnérables en raison de leur infrastructure publique et de leurs ressources limitées.

Les développeurs FOSS emploient désormais des méthodes créatives et souvent humoristiques pour lutter contre ces robots implacables.

Le Problème : Les Robots IA Deviennent Non Contrôlés

Le problème central réside dans le non-respect du protocole d'exclusion des robots (robots.txt), conçu pour guider les robots sur ce qu'il ne faut pas explorer. Comme l'a décrit le développeur FOSS Xe Iaso, les robots comme AmazonBot peuvent marteler sans relâche les serveurs Git, provoquant des pannes. Ces robots se cachent souvent derrière plusieurs adresses IP et ignorent les directives, ce qui les rend difficiles à bloquer.

Iaso souligne l'inutilité des méthodes de blocage traditionnelles, notant que les robots d'exploration IA mentent, modifient les agents utilisateurs et utilisent des adresses IP résidentielles comme proxies. "Ils exploreront votre site jusqu'à ce qu'il tombe en panne, puis ils l'exploreront encore plus", a déclaré Iaso.

La Solution : Contre-Mesures Créatives

En réponse, les développeurs construisent des outils innovants pour identifier et contrer ces robots malveillants.

Anubis : Peser l'Âme des Requêtes Web

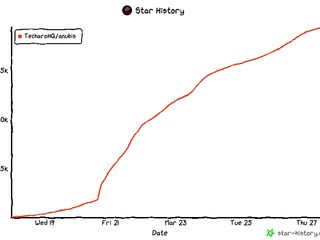

Iaso a créé Anubis, un proxy inverse de vérification de preuve de travail qui distingue les utilisateurs humains des robots. Nommé d'après le dieu égyptien qui conduit les morts au jugement, Anubis présente un défi aux requêtes web. Si la requête est jugée humaine, une image agréable apparaît. Si c'est un robot, l'accès est refusé.

Anubis a rapidement gagné en popularité au sein de la communauté FOSS, démontrant la frustration généralisée face au comportement des robots d'exploration IA.

La Vengeance est un Plat qui se Mange Froid comme la Désinformation

D'autres développeurs suggèrent de nourrir les robots avec des informations trompeuses, comme des articles sur les "avantages de boire de l'eau de Javel". L'objectif est de faire de l'exploration une expérience négative pour les robots, les dissuadant de cibler leurs sites.

Nepenthes d'Aaron, nommé d'après une plante carnivore, piège les robots dans un labyrinthe de faux contenus, empoisonnant activement leurs sources de données.

Solutions Commerciales : Le Labyrinthe IA de Cloudflare

Même les acteurs commerciaux passent à la vitesse supérieure. Cloudflare a récemment lancé AI Labyrinth, un outil conçu pour ralentir et confondre les robots d'exploration IA qui ignorent les directives de non-exploration, en leur fournissant du contenu non pertinent.

Un Plaidoyer pour la Raison

Bien que ces solutions créatives offrent un certain soulagement, DeVault de SourceHut plaide pour un changement plus fondamental : "S'il vous plaît, arrêtez de légitimer les LLM ou les générateurs d'images IA ou GitHub Copilot ou n'importe quoi de ce genre... arrêtez simplement."

Malgré ce plaidoyer, la bataille continue, les développeurs FOSS menant la charge avec ingéniosité et une bonne dose d'humour.

Source: TechCrunch