Aya Vision de Cohere : Modèle d'IA Ouvert pour la Compréhension Multilingue

Cohere For AI, la branche recherche de la startup d'IA Cohere, vient de lâcher une bombe : Aya Vision, un modèle d'IA multimodal "ouvert" qu'ils présentent comme le meilleur de sa catégorie. Mais qu'est-ce que cela signifie réellement pour vous ?

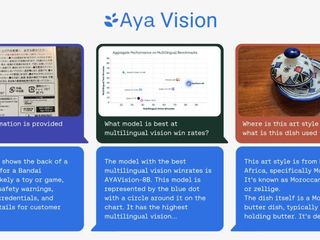

Essentiellement, Aya Vision peut gérer un tas de tâches intéressantes. Pensez à écrire des légendes pour des images, répondre à des questions sur ces photos, traduire du texte comme un pro et même générer des résumés dans 23 langues principales ! Cohere le met même à disposition gratuitement via WhatsApp, dans le but de démocratiser l'accès à la recherche de pointe en IA.

Combler le Fossé Linguistique

Cohere souligne un problème majeur dans le monde de l'IA : le biais linguistique. Les modèles fonctionnent souvent beaucoup mieux en anglais, laissant d'autres langues derrière, en particulier dans les tâches impliquant à la fois des images et du texte. Aya Vision est spécifiquement conçu pour combler cette lacune.

Deux Saveurs d'Aya Vision

Vous avez deux options ici : Aya Vision 32B et Aya Vision 8B. La version 32B est la plus lourde, surpassant apparemment les modèles deux fois plus grands, y compris Llama-3 90B Vision de Meta, sur certains tests de compréhension visuelle. La version 8B se défend également, surpassant même les modèles dix fois plus grands dans certaines évaluations.

Les deux modèles sont disponibles sur Hugging Face sous une licence Creative Commons 4.0, mais il y a un piège : ils ne sont pas destinés à un usage commercial.

Des Données Synthétiques à la Rescousse ?

C'est là que les choses deviennent intéressantes. Aya Vision a été entraîné à l'aide d'un mélange d'ensembles de données en anglais, qui ont ensuite été traduits et utilisés pour créer des annotations synthétiques. Ces annotations agissent comme des balises, aidant le modèle à comprendre et à interpréter les données pendant la formation. Considérez cela comme l'étiquetage d'objets dans une photo afin que l'IA sache ce qu'elle regarde.

L'utilisation de données synthétiques devient de plus en plus courante à mesure que l'offre de données du monde réel diminue. Même OpenAI se joint à la tendance. Gartner estime qu'un stupéfiant 60 % des données utilisées pour les projets d'IA l'année dernière ont été générées synthétiquement.

Cohere affirme que la formation d'Aya Vision avec des annotations synthétiques leur a permis d'atteindre des performances compétitives avec moins de ressources. Cet accent mis sur l'efficacité est crucial, en particulier pour les chercheurs disposant d'une puissance de calcul limitée.

Un Nouveau Benchmark : AyaVisionBench

Cohere ne se contente pas de publier un modèle ; ils introduisent également AyaVisionBench, un nouvel ensemble de benchmarks pour évaluer les compétences d'un modèle dans les tâches de vision-langue. Cela inclut des choses comme repérer les différences entre les images et convertir les captures d'écran en code.

L'industrie de l'IA est confrontée à une "crise d'évaluation" car les benchmarks actuels ne reflètent souvent pas avec précision la façon dont un modèle se comporte dans des scénarios du monde réel. Cohere espère qu'AyaVisionBench résoudra ce problème en fournissant un moyen plus complet d'évaluer la compréhension multilingue et multimodale.

L'Objectif : Une IA Meilleure et Plus Accessible

En fin de compte, l'objectif de Cohere est de créer une IA qui soit non seulement puissante, mais également accessible à un plus large éventail de chercheurs et d'utilisateurs. En se concentrant sur l'efficacité, les capacités multilingues et l'évaluation robuste, Aya Vision pourrait être une étape importante dans la bonne direction.

"[L]'ensemble de données sert de référence robuste pour évaluer les modèles de vision-langue dans des contextes multilingues et réels", ont écrit les chercheurs de Cohere dans un article sur Hugging Face. "Nous mettons cet ensemble d'évaluation à la disposition de la communauté de recherche pour faire avancer les évaluations multimodales multilingues."

Source: TechCrunch